Herr Neumann, seit Jahren erzählt uns die Autoindustrie, dass wir schon bald die Hände vom Lenkrad lassen können, weil die Autos vollautonom fahren werden. Wahrnehmbar passiert allerdings wenig – wenn man davon absieht, dass Mercedes als erster Hersteller weltweit bald Fahrzeuge anbieten wird, die autonom auf Level 3 fahren können – auf der Autobahn, bis Tempo 60. Wie erklären Sie sich die Diskrepanz zwischen den vollmundigen Ankündigungen und den bescheidenen Fakten?

Neumann: Das liegt daran, dass die Autoindustrie die Herausforderungen unterschätzt hat, die mit dem vollautonomen Fahren verbunden sind. Als Google 2014 sein vollautonom fahrendes Knubbel-Auto in Kalifornien vorstellen, haben viele in der Autoindustrie die Versuche damit zunächst als Unsinn bezeichnet. Doch wenig später schwenkte ein Autohersteller nach dem anderen um. GM kaufte „Cruise“, Ford gründete Argo – alle US-Hersteller sprangen auf das Thema. Darüber sind wir alle in der Autoindustrie in eine Euphorie verfallen. Der Eindruck war: Das wird jetzt sehr schnell Realität.

Der Elektrotechnik-Ingenieur startete seine Karriere bei Motorola. Später wechselte er in den Volkswagen-Konzern, wo er zunächst die Elektronik-Entwicklung leitete. Anschließend wechselte er als Technikvorstand zum Autozulieferer Continental, den er zwei Jahre lang leitete. 2009 kehrte er zum VW-Konzern zurück, wo er erst für Elektroantriebe, später für das China-Geschäft verantwortlich war. Es folgten vier Jahre als Chef von Opel. Später war der Marathon-Läufer Vorstand beim kalifornischen E-Auto-Unternehmen Evelozcity/Canoo. Derzeit engagiert sich Neumann bei einer Reihe von Start-ups rund um das autonome Fahren, unter anderem bei Cartica, Apex.AI und als Aufsichtsratschef von Autobrains aus Israel.

Denkste.

Ja, so schnell ging es eben nicht. Selbst John Krafcik, der frühere CEO der Google-Tochter Waymo, glaubt ja inzwischen nicht mehr, dass selbstfahrende Autos jemals komplett ohne menschliche Hilfe auskommen werden.

Sie glauben das auch?

Bis zu Level 5 wird es sehr lange dauern. Wir beide werden das sicher nicht mehr erleben. Trotzdem hat sich an mehreren Stellen enorm viel getan.

Nämlich?

Erstens haben wir jetzt alle Kameras in den Autos, die ziemlich viel erkennen können. Und da sich inzwischen eine ganze Industrie mit dem Thema beschäftigt, die Zahl der Verkehrsunfälle zu reduzieren, werden wir in absehbarer Zeit weitere Fortschritte sehen.

Es geht also in erster Linie um Verkehrssicherheit?

Derzeit ja. Wir erleben derzeit in vielen Ländern, dass die Zahl der Verkehrsunfälle wieder steigt, weil viele Menschen lieber am Handy herumfummeln als das Auto zu lenken. Jedenfalls können sie nicht mal eine halbe Stunde von dem Smartphone lassen. Wir brauchen also Systeme, die verhindern, dass wir in ein anderes Auto oder in einen Radfahrer fahren können, selbst wenn wir abgelenkt sind.

Das selbständige, vollautomatische Einparken zumindest klappt ja schon bei einigen Autos.

Ich glaube deshalb ja auch, dass das autonome Fahren kommt – in Teilbereichen. Man wird das Auto per Knopfdruck in eine Batterie-Wechselstation oder in ein Parkhaus fahren lassen können. Die Assistenzsysteme, die mich entlasten – nicht komplett befreien – sind heute schon recht eindrucksvoll. Stop & Go im Stau funktioniert damit schon sehr gut. Bei Tesla kann man schon seit ein paar Jahren im Autobahn-Verkehr automatisiert fahren – auch wenn nicht immer alles so funktionierte und funktioniert wie versprochen. Dennoch ist es eine extreme Erleichterung für den Autofahrer.

Die Wurzeln von Waymo liegen bei Google. Dort wurde das Projekt unter dem Dach von „Google X“ als „Self Driving Car“ entwickelt. 2014 war die Technologie bereits soweit, dass direkt Autos auf die Straße geschickt werden konnten. Foto: Google

Das heißt, technisch gab es schon eine Menge Fortschritte mit der Verbesserung der Sensorik. Neue Autos sind ja heute mit einer Vielzahl von Kameras, Radar-, Ultraschall und auch schon dem einen oder anderen Lidar-Sensor bestückt. Wo liegt da noch die große Herausforderung? In der Interpretation der Daten?

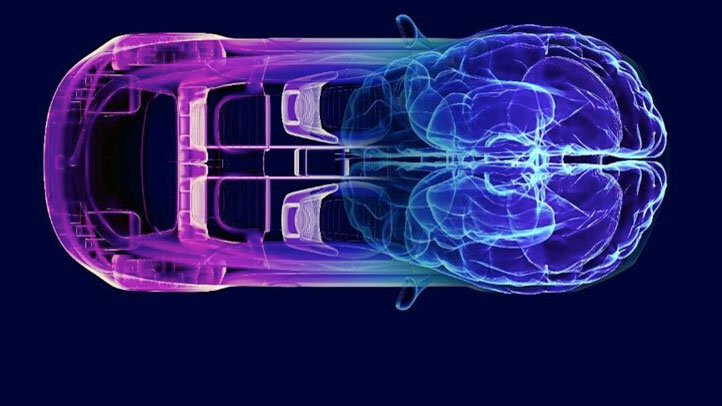

Das ist in der Tat ein Punkt. Alle reden heute davon, dass das Auto ein mobiler Datensammler ist. Das führt dazu, dass alle Daten in einem wassergekühlten Zentralcomputer an Bord zusammenlaufen. Da gibt es einen super leistungsfähigen und Energie-hungrigen Chip, der sehr einfach und schnell Verknüpfungen von Pixeln und Vectoren herstellen können – all der Daten, die von der Sensorik kommen. Der zentrale Computer bildet ein riesiges neuronales Netzwerk, das Milliarden von Operationen pro Sekunde bewältigen kann. Dieses versucht in den Daten dann Muster zu erkennen. Dazu muss man den Rechner trainieren, muss ihm Straßenschilder, Autos, Fahrräder zeigen – damit er sie erstens erkennt und zweitens aus Situationen und Bewegungen die richtigen Schlüsse zieht.

Das klingt in der Tat nach einer großen Herausforderung.

Das ist es auch. Die Systeme kommen heute noch schnell an ihre Grenzen. Denn der Aufwand wird riesig – nicht nur für die Prozessoren. Sondern auch und vor allem für das „Labelling“ und „Teaching“: Ich muss eine Unzahl von Schildern kennzeichnen, egal, ob sie gut oder nur zum Teil zu erkennen sind, ob die Farbe abblättert oder ausgeblichen ist. Es gibt unzählige Grenzfälle zu klären. Und deshalb sitzen da heute Tausende von Menschen auf den Philippinen oder sonstwo, die nichts anderes machen als die Bilder zu interpretieren und zuzuordnen.

Manuell?

Manuell. Und wenn sie nur ein paar Kleinigkeiten in diesem Lehr- und Lernprozess verändern wollen, muss das gesamte neuronale Netzwerk verändert werden.

Wahnsinn.

Das ist ein enormer Aufwand, kann ich Ihnen sagen. Zumal es auch noch so etwas wie „Goofing“ gibt.

Was ist das?

Das bewusste Verwirren von Systemen. Dafür reicht es zum Beispiel, ein T-Shirt mit bestimmten bunten Mustern oder QR-Codes auf der Brust zu tragen. Da flippen manche System aus, weil die Mustererkennung nicht mehr funktioniert.

Wir bräuchten also künftig Kleidervorschiften für Fußgänger und Radfahrer?

Für konventionelle KIs wäre es gut, wenn sie immer das anziehen würden, was die Dummies bei den Versuchen tragen – ein rotes T-Shirt und eine schwarze Hose.

Und Autobrains, das israelische KI-Start-up, an dem Sie beteiligt sind und bei dem Sie den Aufsichtsrat leiten, kann die skizzierten Probleme lösen?

Autobrains hat einen komplett anderen Ansatz. Das Unternehmen kommt, wie dort so oft, aus der Rüstungsindustrie. Die haben vor Jahren Experimente mit Mäusen zur Hirnfoschung gemacht, um zu verstehen, wie das Gehirn arbeitet.

„Wir haben eine selbstlernende KI – im Unterschied zum Deep Learning. Deshalb braucht unser System nur zehn Prozent der Rechenleistung.“

Und was dabei herausgefunden?

Dass nicht alle Bilder, die mit den Augen aufgenommen werden, komplett abgespeichert werden. Erkannt werden nur typische Strukturen – horizontale und vertikale Linien, Farben und anderes. Ein Neugeborenes bildet daraus Signaturen. Eine Flasche beispielsweise wird dann an typischen Signaturen erkannt, egal, wie groß sie ist, welche Farbe sie hat oder ob man nur einen Teil davon sieht. Und so funktioniert auch das KI-System von Autobrains: Wir bilden Signaturen und eine bestimmte Menge von Signaturen ordnen wir dann zum Beispiel einem Stoppschild zu. Dann muss man auch nicht mehr alle möglichen Zustände von Stoppschildern lehren. Das System kommt vielmehr selbst zu dem Schluss, dass das Teil am Straßenrand mit hoher Wahrscheinlichkeit ein Stoppschild ist.

Die Entwicklung der menschlichen Wahrnehmung wird also mit Künstlicher Intelligenz nachgebildet?

So kann man das sagen. Wir haben eine selbstlernende KI – im Unterschied zum Deep Learning, also dem erwähnten Teaching. Deshalb braucht unser System auch nur etwa zehn Prozent der Rechenleistung.

Das sollte überzeugen.

Das tut es heute, aber war vor vier Jahren noch nicht der Fall. Erst jüngst ist einiges in Bewegung gekommen. Google hat inzwischen große Abteilungen, die sich mit selbstlernender AI auseinander setzt. Denn man hat erkannt, dass Deep Learning an seine Grenzen kommt. Um die letzten Fehler zu beseitigen, wird es irrsinnig aufwändig und entsprechend teuer. Es braucht dafür einen ganzen Lehrkörper, wenn Sie so wollen. Für die selbstlernende KI braucht es nur einen Lehrer und entsprechend weniger Rechenleistung. Und trotzdem ist der Erkenntnisgewinn und Treffergenauigkeit größer.

Weniger Aufwand, mehr Gewinn – das klingt nach einer Erfolgsformel.

Das ist so. Eine kleine Kamera im Auto können wir mit zehn Prozent des Energieaufwands und der Reichenleistung betreiben, die heute erforderlich ist.

So nimmt die Software von Mobileye die Welt wahr.

© Copyright Mobileye

Sie fangen also mit einem rein bildgestützten System an?

Das ist unser Markteinstieg. Am Ende können wir das mit jedem Sensor machen. Eine Kamera liefert Pixel und ein mehr oder minder verrauschtes Bild der Umgebung. Entfernungen lassen sich damit allein schwer abschätzen. Bei Nebel oder Regen hilft uns die Kamera allein auch wenig. Radar kann die Entfernung und die Geschwindigkeit eines Objekts sehr genau messen, aber damit kriegt man nie die hohe Auflösung, die notwendig ist, um einen Radfahrer vom Fußgänger unterscheiden zu können. Oft werden die Informationen beider Systeme separat ausgewertet. Wir machen das anders.

Nämlich?

Beide Systeme bilden typische Signaturen – und die legen wir übereinander. Damit verlieren wir weniger Informationen als bei der separaten Methodik. Waymo und Cruise werten sämtliche Pixel aus und verrühren die in einem neuronalen Netzwerk miteinander. Aber das erhöht den Aufwand in dem Netzwerk exponentiell.

Demnach hat AutoBrains also schon so etwas wie eine Patentlösung parat. Wozu braucht es dann neue Finanzierungsrunden? Woran muss noch gearbeitet werden?

Die Industrialisierung des Systems ist natürlich noch sehr aufwändig. Wir brauchen Fahrversuche, bauen dazu jetzt eigene Testfahrzeuge auf. Wir stellen zusätzliches Personal ein, das direkt am Kunden arbeiten kann. Aber wir haben dafür ja starke Partner: BMW, Continental, Toyota. Jetzt ist noch Knorr-Bremse dazugekommen, die das System auf Lastwagen anwenden möchte. Auch mit einem Motorradhersteller arbeiten wir zusammen. Denn in Schräglagen funktioniert das Deep Learning nicht mehr – unser System schon.

Dann sollte es doch kein Problem sein, Kunden zu gewinnen.

Einfach wird es nicht. Denn Mobileye hat heute einen Marktanteil von bis zu 70 Prozent. Die sind gut, aber auch sehr teuer. Viele Kollegen hassen die deshalb regelrecht. Andere lieben sie – weil sie wissen, dass es damit funktioniert. Wir sagen: Wir können das auch – aber mit weniger Aufwand. Jetzt müssen wir es nur noch beweisen. Das gilt auch für unsere Theorie vom Autonomen Fahren.

„Die Vorstellung, dass wir bald das Lenkrad einklappen und uns im Auto hinlegen können, ist Quark.„

Wie lautet die?

Die Waymos dieser Welt setzen auf neuronale Netze, die angelernt werden müssen, damit das Auto nicht durch einen Vorgarten fährt. Zumindest nicht so oft, denn so ganz sicher sind die sich nicht. Wir sagen: Das menschliche Gehirn arbeitet auch hier anders. Es kann während einer Autobahn-Fahrt auch noch einem Hörspiel lauschen – hellwach wird es erst, wenn jemand die Kreise stört. Dann mobilisiert es alle Kräfte, um einen Unfall zu vermeiden.

Richtig: Eine Gefahrensituation zu erkennen, ist der erste Schritt. Im zweiten muss eine Reaktion erfolgen.

Deshalb halten wir es für falsch, ein riesiges Gehirn zu haben, das gleichzeitig alles analysiert und darüber nachdenkt, ob sich das Auto gerade auf der Autobahn oder in einem Kreisverkehr bewegt.

Damit kann man die Rechenleistung reduzieren?

Genau. Es ist ja absurd viel, was an Rechenleistung inzwischen in die Autos reinkommt.

Das bedeutet aber, dass einige Autohersteller ihr System für das Autonome Fahren komplett überdenken müssen.

Richtig, das ist die Herausforderung. Aber viele sind dafür offen, weil ihnen die Abhängigkeit von Mobileye zu groß geworden ist.

Das Lenkrad verschwindet auf Knopfdruck, das Auto wird zum rollenden Schlafsaal – Audi-Designer machen sich bereits intensiv Gedanken über die Zukunft des vollautomatischen Fahrens – und das Luxusauto von übermorgen. Foto: Audi

Warum?

Mobileye hat mit Kameras angefangen. Darin sind die auch sehr gut. Inzwischen nehmen sie auch Radar hinzu – verlangen aber von ihren Kunden, auch ihre Chips zu nutzen. Und alles drumherum. Das wollen die OEM aber nicht, sondern die Systemkompetenz behalten. Wir hingegen machen nur die Software – die Hardware können die Hersteller selbst wählen und integrieren. Wir sind eine reine Software-Company. Autobrains-Software für die Mustererkennung und Agenten – so nennen wir Bewegungsmuster – werden im Auto in jeder Kamera sein, in jedem Radar- und Lidarsensor und in den Zentralcomputern. Das wird ein reines Lizenzgeschäft – für das Auto, das zu einem Softwaresystem wird. Mit weltweit zwei oder drei Betriebssystemen, aber auf keinen Fall zehn. Eines davon wird hoffentlich Apex AI sein.

An dessen Entwickler Sie ebenfalls beteiligt sind. Müsste nicht eigentlich Mobileye ein Interesse haben, Autobrains zu übernehmen?

Puh. Mobileye fühlt sich im Augenblick sehr stark. Und das sind sie ja auch. Das Unternehmen hat eine Börsenbewertung von knapp 60 Milliarden Dollar! Und jeder will jetzt der nächste Mobileye werden.

Autobrains nicht auch?

Doch (Lacht) Aber die anderen versuchen Mobileye auf deren eigenem Feld zu schlagen. So lassen die sich nicht ein- oder gar überholen. Bei Autobrains haben wir die nächste Technologie – und die Möglichkeit, vorbeizuziehen.

Was bedeutet all das für die Vision vom vollautonom fahrenden Auto?

Wie gesagt: So schnell werden wir nicht auf Level 5 kommen – also vollständige Autonomie bei jedem Wetter und in jeder Umgebung. Aber Level 3 und Level 3+ sind in Reichweite. Und die Chinesen bauen inzwischen Städte für autonom fahrende Autos. Wir könnten sofort in Las Vegas sofort den Strip für alle Autos schließen und dort nur noch Robo-Shuttles fahren lassen. Das würde funktionieren. Und in dieser Richtung werden wir in den nächsten Jahren sicher noch eine Menge sehen. Auch können wir sicher bald auf der Autobahn mehrere Fahrzeuge zum Konvoi zusammenschließen. Aber die Vorstellung, dass wir bald das Lenkrad auf Knopfdruck einfahren und uns im Auto hinlegen können, das ist einfach Quark.